ChatGPT’yi yaratan şirketin ardındaki Sam Altman, Yapay zeka teknolojisinin bildiğimiz toplumu yine şekillendireceğine inanıyor. Altman, bu teknolojinin gerçek tehlikeleri de beraberinde getirdiğine fakat tıpkı vakitte hayatlarımızı Aka ölçüde düzgünleştirmek için “insanlığın şimdiye kadar geliştirdiği en Aka teknoloji” olabileceğine inanıyor.

ChatGPT’yi yaratan şirketin ardındaki Sam Altman, Yapay zeka teknolojisinin bildiğimiz toplumu yine şekillendireceğine inanıyor. Altman, bu teknolojinin gerçek tehlikeleri de beraberinde getirdiğine fakat tıpkı vakitte hayatlarımızı Aka ölçüde düzgünleştirmek için “insanlığın şimdiye kadar geliştirdiği en Aka teknoloji” olabileceğine inanıyor. “Geceleri beni uykusuz bırakıyor”

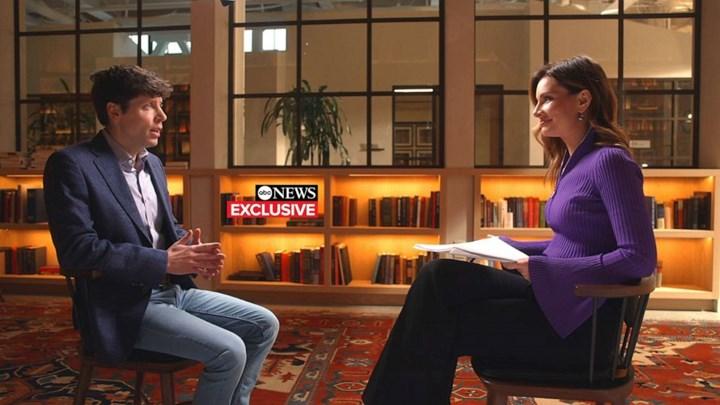

OpenAI CEO’su Sam Altman ABC News’e verdiği röportajda Yapay zeka teknolojisinin işgücünü, seçimleri ve dezenformasyonun yayılmasını etkileyebileceğinden “korktuğunu” söyledi. ChatGPT ve GPT-4 üzere Yapay zeka modellerinin muvaffakiyetinden gurur duysa da Altman, Yapay zekanın mümkün tehlikeli uygulamalarının kendisini uykusuz bıraktığını kabul etti.

Sam Altman, yaptığı açıklamalarda hem düzenleyicilerin hem de toplumun ChatGPT üzere Yapay zekaların yaygınlaştırılmasına ve geliştirilmesine olabildiğinde iç olmaları gerektiğini ve bu sayede potansiyel Olumsuz sonuçların ortadan kaldırılabileceğini Anlatım ediyor. OpenAI’ın tıpkı vakitte nizamlı olarak hükümet yetkilileriyle temas halinde olduğu da belirtiliyor.

Sam Altman, yaptığı açıklamalarda hem düzenleyicilerin hem de toplumun ChatGPT üzere Yapay zekaların yaygınlaştırılmasına ve geliştirilmesine olabildiğinde iç olmaları gerektiğini ve bu sayede potansiyel Olumsuz sonuçların ortadan kaldırılabileceğini Anlatım ediyor. OpenAI’ın tıpkı vakitte nizamlı olarak hükümet yetkilileriyle temas halinde olduğu da belirtiliyor. Sadece birkaç ay Evvel piyasaya sürülen ChatGPT, şimdiden tarihin en süratli büyüyen tüketici uygulaması olarak kabul ediliyor. ChatGPT sadece birkaç ay içinde aylık 100 milyon faal kullanıcıya ulaşarak rekor kırdı. TikTok‘un bu kadar kullanıcıya ulaşması dokuz ay, Instagram‘ın ise yaklaşık üç yıl sürdüğünü belirtelim.

Otoriter ülkeler endişelendiriyor

Altman, eninde sonunda Yapay zeka teknolojisinin “iyi” potansiyelinin öne çıkacağını söylese de “otoriter rejimler” tarafından geliştirilen rakip Yapay zekalar konusunda da telaşlı olduğunu belirtti. Öte yandan Çinli teknoloji şirketi Baidu, kısa bir müddet Evvel ChatGPT rakibi Ernie Bot’u tanıtmıştı. Rusya Devlet Lideri Vladimir Putin, Yapay zeka teknolojisinde lider olanın “dünyanın hakimi olacağını” söylemişti. Altman bu yorumları “tüyler ürpertici” olarak nitelendirdi.

Altman, eninde sonunda Yapay zeka teknolojisinin “iyi” potansiyelinin öne çıkacağını söylese de “otoriter rejimler” tarafından geliştirilen rakip Yapay zekalar konusunda da telaşlı olduğunu belirtti. Öte yandan Çinli teknoloji şirketi Baidu, kısa bir müddet Evvel ChatGPT rakibi Ernie Bot’u tanıtmıştı. Rusya Devlet Lideri Vladimir Putin, Yapay zeka teknolojisinde lider olanın “dünyanın hakimi olacağını” söylemişti. Altman bu yorumları “tüyler ürpertici” olarak nitelendirdi. Altman ayrıyeten yaptığı açıklamalarda “Bu modellerin Aka ölçekli dezenformasyon için kullanılabileceğinden Özellikle endişeliyim” dedi. “Artık bilgisayar kodu yazmaya başladıklarına nazaran, modeller saldırgan siber saldırılar için kullanılabilir” ifadelerini kullanan Altman, aslında Yapay zekanın karanlık yüzüne Fer tutuyor.

Yapay zeka halüsinasyonu

OpenAI’ye nazaran GPT-4, imajları girdi olarak manaya yeteneği de iç olmak üzere bir evvelki iterasyona nazaran Aka iyileştirmelere sahip. Demolarda GTP-4’ün birinin buzdolabında ne olduğunu açıkladığı, bulmacaları çözdüğü ve hatta bir internet meme’inin ardındaki manası Anlatım ettiği görülüyor.

Ancak Altman’a nazaran ChatGPT üzere Yapay zeka lisan modelleriyle ilgili en Aka Problem yanlış bilgilendirme. ChatGPT yahut öbürleri, kullanıcılara gerçekte doğru olmayan bilgiler verebiliyor. Üstelik bu yanlış bilgileri kendinden emin bir biçimde savunuyor ve ardında duruyor. Buna yapay zeka halüsinasyonu deniyor. OpenAI’ye nazaran modelin bu sorunu kısmen, ezber yerine tümdengelimli akıl yürütme kullandığı için yaşanıyor. Lakin OpenAI, modellerinin ezber yapmasını değil muhakeme yeteneğine dayalı sonuçlar vermesini istiyor. Altman ve grubu, modellerinin eninde sonunda gerçeği kurgudan ayırmak için interneti ve kendi tümdengelimli muhakemesini kullanacağına inanıyor.

Yorum Yok